Виталик Бутерин поддержал новый метод компрессии изображений TiTok AI

Метод компрессии TiTok был разработан исследователями из ByteDance и Технического университета Мюнхена. Согласно исследовательской работе TiTok, продвинутая технология искусственного интеллекта для сжатия изображений позволяет сжимать изображение размером 256x256 пикселей в 32 дискретных токена

Сооснователь Ethereum Виталик Бутерин поддержал новый метод компрессии изображений под названием TiTok. Этот метод значительно уменьшает размер изображения, делая его более практичным для хранения в блокчейне.

Бутерин подчеркнул потенциал TiTok для блокчейн-приложений на децентрализованной социальной платформе Farcaster, заявив: "320 бит - это по сути хэш. Достаточно маленький, чтобы поместиться в цепочку для каждого пользователя".

Это может иметь значительные последствия для цифрового хранения изображений профилей пользователей (PFP) и невзаимозаменяемых токенов (NFT).

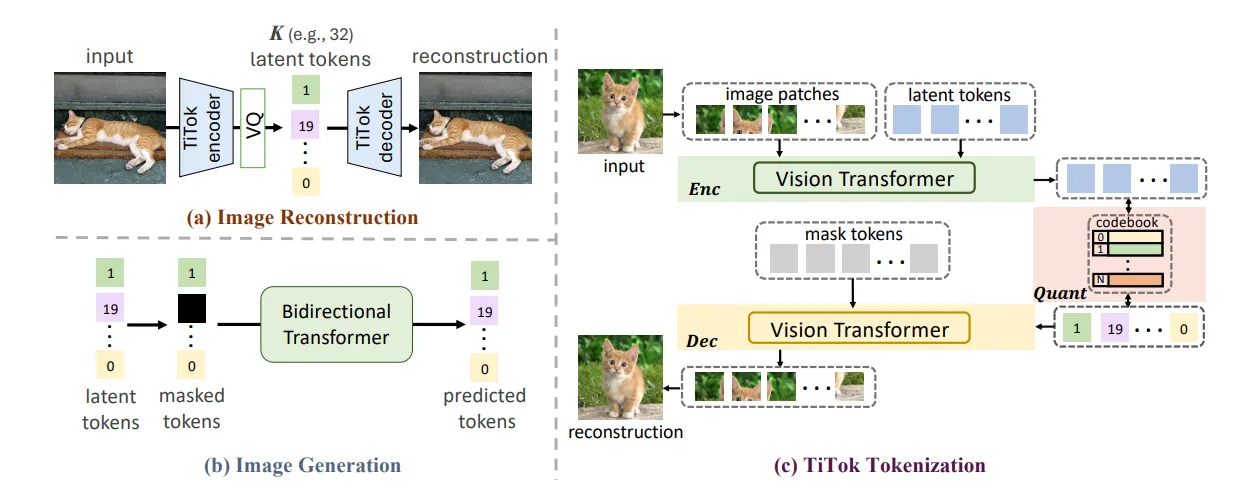

Метод компрессии изображений TiTok был разработан исследователями из ByteDance и Технического университета Мюнхена. Он позволяет сжимать изображение в 32 небольших кусочка данных (бит), при этом качество изображения не теряется. Согласно исследовательской работе TiTok, продвинутая технология искусственного интеллекта для сжатия изображений позволяет сжимать изображение размером 256x256 пикселей в "32 дискретных токена".

TiTok представляет собой 1-мерный (1D) фреймворм для токенизации изображений, который "разрушает ограничения сетки, существующие в 2D методах токенизации", что приводит к более гибким и компактным изображениям.

"В результате это приводит к существенному ускорению процесса выборки (например, в 410 раз быстрее, чем DiT-XL/2) при сохранении конкурентоспособного качества генерации." Использование машинного обучения и продвинутого ИИ TiTok использует машинное обучение и продвинутый ИИ, используя модели трансформатора для преобразования изображений в токенизированные представления.

Метод использует избыточность региона (region redundancy), что означает идентификацию и использование избыточной информации в разных частях изображения для уменьшения общего размера конечного продукта.

"Последние достижения в области генеративных моделей подчеркнули ключевую роль токенизации изображений в эффективном синтезе высококачественных изображений." Исследовательская работа TiTok утверждает, что "компактное представление латентности" TiTok может обеспечить "существенно более эффективные и эффективные представления, чем традиционные методы".